A distância entre os modelos proprietários de elite do Ocidente e o ecossistema de código aberto da China acaba de diminuir drasticamente. Neste domingo (1º), a DeepSeek, startup de inteligência artificial sediada em Hangzhou, anunciou o lançamento de dois novos modelos de raciocínio: o DeepSeek-V3.2 e sua variante de alta performance, o DeepSeek-V3.2-Speciale.

A promessa é audaciosa: entregar desempenho de nível “state-of-the-art” (SOTA), rivalizando diretamente com pesos pesados como o GPT-5 da OpenAI e o Gemini 3 Pro da Google, mas com uma filosofia open-source.

Os números falam: Benchmarks de nível ouro

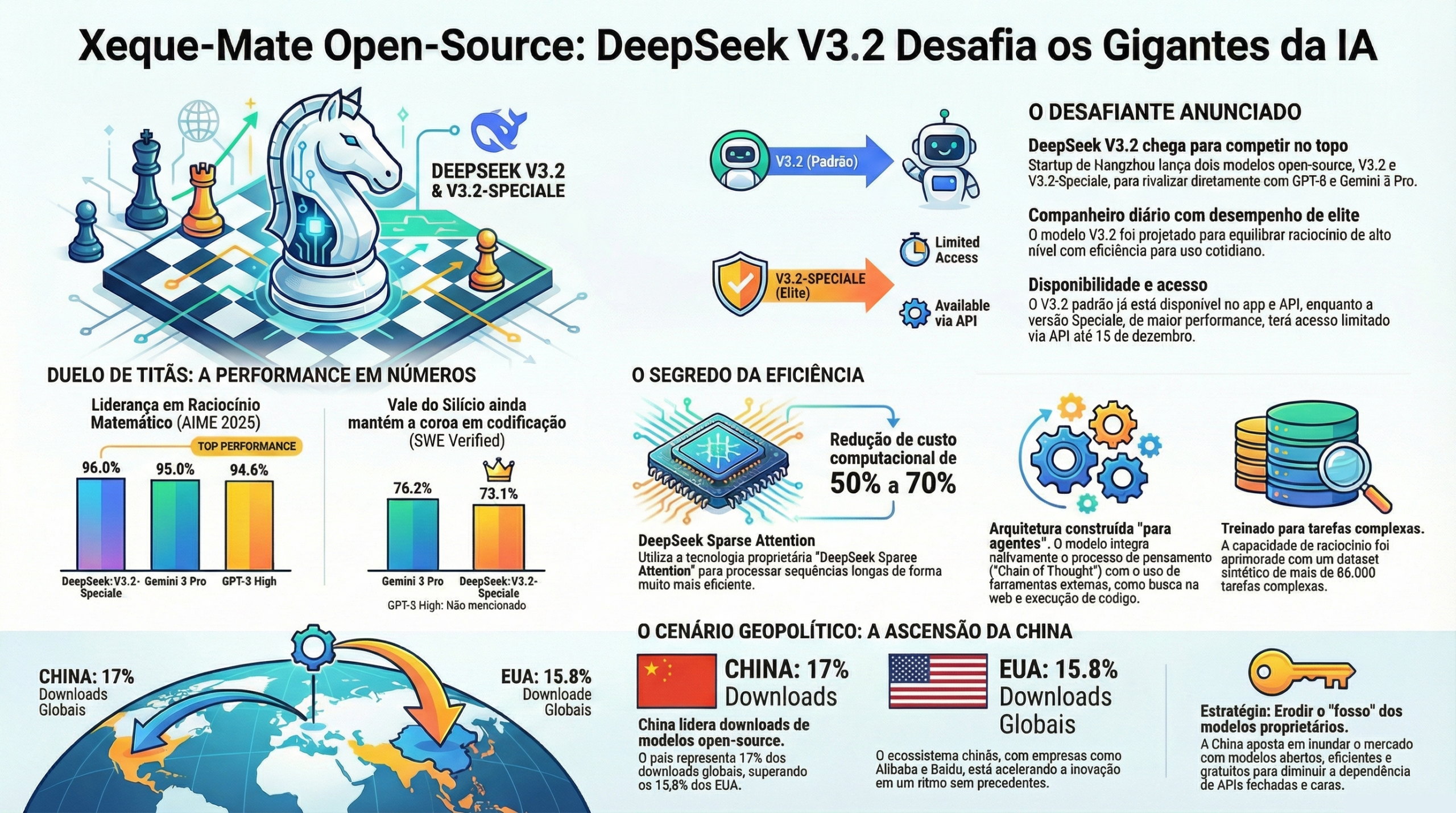

Para o público técnico e entusiastas, o que importa são os dados brutos. O modelo V3.2-Speciale demonstrou resultados impressionantes em benchmarks matemáticos e de lógica, áreas historicamente dominadas por modelos fechados.

No Exame de Matemática por Convite Americano (AIME) 2025, o cenário foi de reviravolta:

-

DeepSeek-V3.2-Speciale: 96,0%

-

Gemini 3 Pro: 95,0%

-

GPT-5 High: 94,6%

Além disso, o modelo obteve resultados de “nível ouro” em quatro das competições mais difíceis do mundo, incluindo a Olimpíada Internacional de Matemática e as Finais Mundiais da ICPC.

No entanto, o Vale do Silício ainda segura a coroa em codificação pura. No benchmark SWE Verified, que avalia engenharia de software autônoma, o Gemini 3 Pro lidera com 76,2%, enquanto o DeepSeek-V3.2-Speciale segue de perto com 73,1%.

Eficiência como arma estratégica

O lançamento do V3.2 não é apenas sobre pontuações, é sobre acessibilidade. Financiada pelo fundo quantitativo High-Flyer, a DeepSeek aposta na eficiência para contornar as restrições de exportação de chips avançados impostas pelos EUA.

O relatório técnico revela o uso do DeepSeek Sparse Attention, um mecanismo proprietário que reduz o custo computacional no processamento de sequências longas (context windows) em 50% a 70%. Isso permite que modelos poderosos rodem em hardwares menos potentes, democratizando o acesso à IA de ponta.

“O V3.2 foi projetado como ‘seu companheiro diário com desempenho nível GPT-5’, equilibrando raciocínio e eficiência de inferência,” afirmou a empresa em comunicado.

Sob o capô: Raciocínio integrado a ferramentas

Tecnicamente, a DeepSeek introduz uma inovação interessante na arquitetura dos modelos. O V3.2 é descrito como um modelo “construído para agentes”. Diferente de iterações anteriores, ele integra o processo de pensamento (“Chain of Thought”) diretamente ao uso de ferramentas.

Isso significa que o modelo alterna fluidamente entre raciocínio abstrato e a execução de comandos externos (como busca na web ou execução de Python), treinado em um dataset sintético de mais de 85.000 tarefas complexas.

O Contexto geopolítico: A ascensão do Open Source chinês

Este lançamento solidifica uma tendência apontada por um estudo recente do MIT e Hugging Face: a China ultrapassou os EUA em downloads de modelos open-source (17% vs 15,8% globalmente).

Com concorrentes domésticos como a Alibaba (cujo Qwen 3 também gabaritou o AIME 2025) e a Baidu acelerando o passo, o ecossistema chinês já é responsável por 70% das patentes globais de IA. A estratégia é clara: inundar o mercado com modelos abertos, eficientes e gratuitos, erodindo o “fosso” (moat) de empresas que dependem de APIs fechadas e caras.

Disponibilidade

O DeepSeek-V3.2 padrão já substitui o modelo experimental anterior no app e API da empresa. Já o poderoso V3.2-Speciale, focado em “capacidades de raciocínio maximizadas”, estará disponível via API por tempo limitado, até 15 de dezembro, sugerindo um custo de inferência elevado que a empresa ainda está tentando otimizar.

O que isso significa para você? Se você é desenvolvedor, a barreira de entrada para criar aplicações com inteligência de nível GPT-5 acabou de cair. Se o DeepSeek V3.2 cumprir o que promete no uso real, a justificativa para pagar caro por tokens de modelos proprietários ficará cada vez mais difícil de sustentar.